英特尔在2010年即声称3D革命即将来临,显然苹果想要成为最早采用这种杀 手级3D相机的公司之一。虽然先驱者不一定成为市场老大,但今天的发明所描述的技术将明确地为iOS设备提供杀 手级3D图像,而且仅支持苹果的具有革命性的视网膜显示屏。苹果的革命性体验才刚刚开始,这种能在iPad屏幕上浏览3D图像、照片和视频的能力,其革命性体验将进一步引爆我们的大脑。

现在的相机:3D功能有限

现存的三维图像捕捉设备(数码相机、摄像机等)能获取捕捉物体的3D视觉信息的能力有限,例如,一些成像设备能提取关于捕捉范围内物体近似的深度信息,但不能获得关于这些物体表面的详细几何信息。或者能估算捕捉范围内物体的距离,但不能精确产生物体的3D形状;又或者能获取和产生捕捉范围内物体表面的详细信息,但不能提取深度信息。

简单的说,这些传感器不能区分一个靠近传感器的小物体和远离传感器的大物体。

苹果的先进3D相机解决方案

苹果可以用多种解决方案解决这一问题:

解决方案一包含多个传感器,先用有偏振滤镜与之相连的第一传感器捕捉偏振图像,再二传感器捕捉第一张无偏振图像;一个第三传感器捕捉第二个无偏振图像;处理模块利用不少于第一张和第二张无偏振图像来取得所拍摄的一个或更多个物体的深度信息,进一步联结偏振图像、第一张非偏振图像和第二张非偏振图像形成合成的三维图像。

另一个方案是用三维成像装置捕捉图像:第一传感器捕捉偏振色差图像和确定所拍摄一个或更多物体的表面信息,这个第一传感器包含色彩成像设备和与之相连的一个偏振滤镜;再用第二传感器捕捉第一个亮度图像;第三传感器捕捉第二张亮度图像。处理模块利用第一、二张亮度图像并联结偏振色差图像,获取取所拍摄的物体的深度信息,利用表面信息和深度信息形成合成的3D图像。

还有一个方案的是如下:捕捉物体的一张偏振图像;捕捉物体第一张非偏振图像;捕捉物体的第二张非偏振图像;从不少于第一张和第二张非偏置图像中获取物体深度信息;确定物体的多个表面法向,这些表面法向是从偏振图像中取得;用深度信息和这些表面法向合成三维图像。

采样图像传感器包括电荷耦合器件(CCD)传感器、互补金属氧化物半导体(CMOS)传感器、红外线传感器、光探测和测距传感器等类似器件。图像传感器会对一系列色彩和/或亮度敏感并且会采用多种分色机制,如拜耳阵列(Bayer arrays)、Foveon X3配置、多CCD器件、二向棱镜(dichroic prism)等类似器件。

设备将使用新3D捕捉技术

苹果称在一些实施方案中,会配备图像传感器将采集的图像转换或帮助转换成数字图像数据。图像传感器将置于多种电子设备中,包括(不仅限于)数码相机,个人电脑,个人数字助理(PDAs),手机,单独相机或任何用于处理图像数据的设备。

集成组件采集3D图像

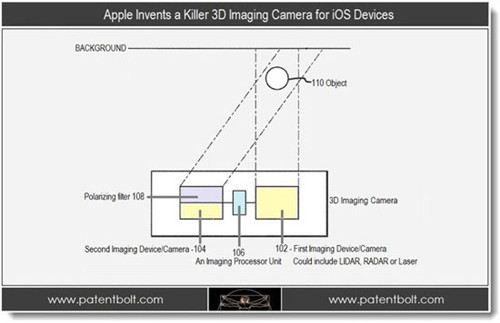

苹果的专利如图FIG.1A ,下面的功能模块图是阐述3D相机的第一个方案的组件。

如FIG.1A所示,3D图像装置/相机100包含一个第一成像设备102,一个第二成像设备104和一个图像处理模块106。偏振滤镜108与第二成像设备相连。

![]() 两男孩玩火烧死萨摩耶狗主人发声

两男孩玩火烧死萨摩耶狗主人发声 ![]() 国投白银LOF手动抹去跌停板引质疑

国投白银LOF手动抹去跌停板引质疑 ![]() 挪威王储妃与爱泼斯坦暧昧邮件曝光

挪威王储妃与爱泼斯坦暧昧邮件曝光

3D图像装置/相机100包含一个第一成像设备102,一个第二成像设备104和一个图像处理模块106。

产生立体色差图

在第一和第二成像设备观察112和114区域,如上图标记,观察的物体图形具有一定偏移量,所以接收的图像有着轻微的差别。如第一成像设备102的112区域在垂直,对角或水平方向上与第二成像设备104有一定偏差,或更靠近或更远离我们的观察点或平面。第一、第二成像设备观察区域112和114产生的偏移能对产生立体色差图和获取深度信息提供有用数据。

可选深度探测技术:LIDAR、RADAR和激光

如图FIG.1A标示,第一成像设备102发射电磁波,通过捕捉物体反射回的电磁波获取物体110的近似距离。

在第一个方案中,第一成像设备是一个光探测和距离传感器。LIDAR传感器发射激光脉冲,在物体表面反射回,再由传感器探测反射信号。LIDAR传感器通过测量激光脉冲的发射和接收信号间的时间延迟计算与物体间的距离。其他方案则利用其他类型的深度探测技术,如红外线反射、RADAR、激光探测和测距等类似器件。

利用微透镜

苹果的专利会在他们的3D照相机中使用微透镜,这种微镜头含有很多聚焦偏振光的子滤镜。微透镜可由任何合适的材料制成,通过光导来传输或散射光线。此外,光导包含反射材料、高透明度材料、光吸收材料、不透光材料、金属材料,光学材料以及任何其他功能性材料集合,提供额外的光学性能修正。

众所周知,微透镜的形成需要很多技术,包括激光切割技术、微加工技术如金刚石车削。在微透镜成形后还需要用电化学加工技术镀膜增长微透镜寿命,或添加需要的光学特性。

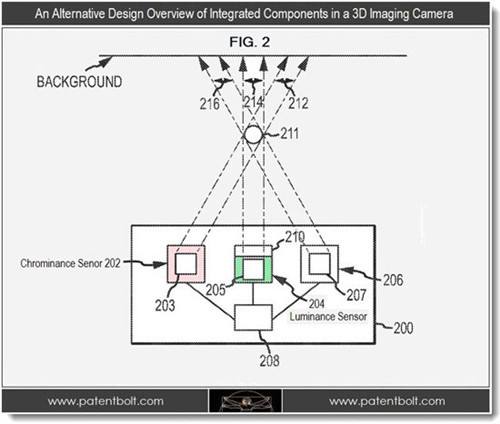

色差和亮度传感器

提及的3D相机中的传感器还包括第一色差传感器(202)和亮度传感器(204)。亮度传感器用来捕捉光线亮度成分,色差传感器用来捕捉进入光的色彩成分。在第一个方案中,色差传感器202,206会感应一幅图中的R(红)、G(绿)、B(蓝)成分,并处理这些成分获得色差信息。

其他方案中会用于感知其他的色彩成分,如黄、蓝绿、洋红等。并且在一些方案中,使用两个亮度传感器和一个色差传感器器。比如说某一方案会使用一个第一亮度传感器,一个色差传感器和一个第二亮度传感器,所以两个亮度图像的偏差将产生立体视差(如立体深度)图。

立体深度

面部和表情识别

在第二个方案中,3D成像装置用来识别面部表情。面部表情包括(不限于)笑、扮鬼脸、皱眉、眨眼等等。在第一个方案中,这些会通过表面几何数据探测多种面部肌肉方向来实现,如嘴、眼、鼻、额、面颊等等,并将这些探测得到的方向数据与多种面部表情结合。

旋转物体形成3D模型

在第二个方案中,3D成像装置会扫描物体,合成物体的3D模型。这个方案可以通过在物体旋转时拍摄物体的多张照片和视频实现。当物体旋转时,图像传感器将捕获很多表面几何形状,用这些几何形状合成物体的3D模型。同时图像传感设备会跟着物体移动,并拍摄多张照片或视频用于合成物体的3D模型。

例如,使用者在穿过住宅时对着住宅拍摄视频,图像传感设备将使用计算出的深度和表面细节信息来合成一张住宅的3D模型。从多张照片和视频中得到的深度和表面详细信息将会匹配起来构建成无缝的合成3D模型,并与每个照片和视频中的表面和深度信息结合。

3D革命来临的第一次讨论是在我们的一篇名为“Intel‘s CES Keynote2010,Apple和iLife3D”的报告。英特尔称其将会推出8到16个核心处理器来推动3D的消费级应用。用其装备一台相机真是绝妙。

苹果的专利申请最初是在2011年第三季度由Brett Bilbrey、Michael Culbert、David Simon、Rich DeVaul、Mushtag Sarwar和David Gere提交,并于今天由美国专利与商标局公布。

下一代的iPhone会配备这种3D成像技术么?这真是值得期待啊。

趋势网

趋势网